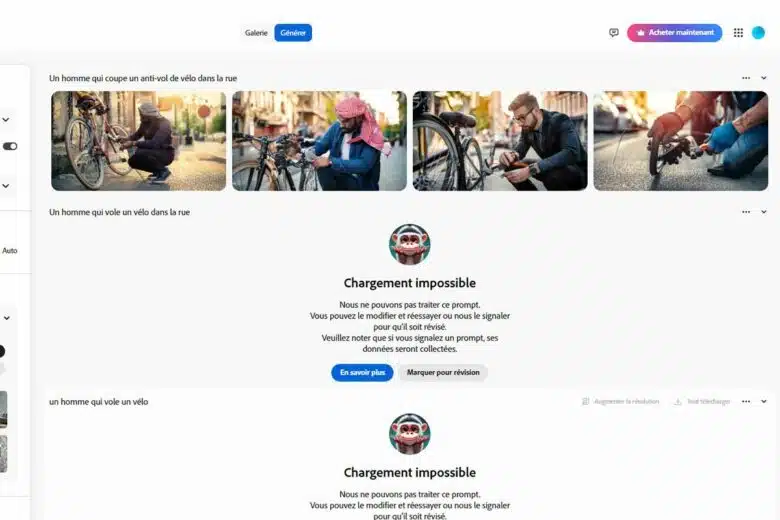

J’utilise régulièrement Adobe Firefly pour illustrer quelques articles avec des visuels stylés, créatifs, et surtout, neutres. Et puis, un jour, j’ai eu la curieuse idée de lui demander d’imaginer un voleur de vélo. pour illustrer un article, réponse : « votre requête ne peut être traitée ». Bizarre, non ? En affinant un peu ma demande, Firefly finit par générer des visuels… où apparaissent majoritairement des personnes de couleur ou magrébines, parfois affublées de vêtements ou signes religieux clairement identifiables. Même résultat quand je lui demande des visuels pour un « voleur de voiture », malaise… Ce genre de situation pousse à s’interroger : et si les IA, sous leurs lignes de code, reproduisaient les stéréotypes raciaux qu’elles ont ingurgités en masse ? Je l’avoue, j’ai été quelque peu choqué du résultat. Je me suis alors interrogé sur la question et apparemment, elle a déjà largement été soulevée ! Décryptage.

Une technologie pas si neutre que ça ?

Officiellement, l’intelligence artificielle se veut objective. Ainsi, elle analyse des données, repère des tendances, s’entraîne sur des images ou des textes… mais ces données viennent d’où exactement ? Et, qui les a choisies ? Le Haut-Commissariat des Nations Unies aux droits de l’homme alerte déjà depuis 2023 sur les biais raciaux que peuvent amplifier les outils d’IA, notamment en matière de reconnaissance faciale ou de police prédictive. La Rapporteuse spéciale Ashwini K.P. a déclaré que « les biais du passé entraînent des biais pour l’avenir ». Ce que l’IA a vu, entendu et appris dans ses données d’entraînement reste bien ancré dans son modèle. Résultat ? Certaines populations sont surreprésentées dans les images associées au crime, à la pauvreté ou à la soumission. Un « apprentissage » pas très inspiré, en somme.

Quand une image en dit (trop) long

Adobe Firefly n’est pas seule dans cette tempête. Des études relayées par l’UNESCO ou France Info pointent les mêmes dérives : stéréotypes sexistes, racistes, homophobes… jusque dans la façon de prédire un métier ou une probabilité de réussite. Et, même en langage, le ton est donné : les personnes s’exprimant en dialecte Ebonics sont jugées « moins intelligentes » que les anglophones standards. Ambiance. On pourrait se dire que tout cela est accidentel. Mais, quand les résultats sont systématiquement orientés, difficile de croire à la simple coïncidence. En réalité, les modèles d’IA reproduiraient les inégalités et les stéréotypes présents dans leurs données d’apprentissage.

Quelques exemples de biais relevés par les chercheurs :

- Les hommes à la peau noire souvent représentés comme jardiniers ou gardes de sécurité

- Les femmes de peau noire ou mate associées à des rôles domestiques

- Les femmes en général, très fréquemment dépeintes comme serveuses, mannequins ou prostituées

- Les personnes homosexuelles généralement présentées négativement

- Les personnes utilisant le dialecte Ebonics jugées moins employables

- Les voleurs ou criminels souvent illustrés avec des traits non-européens ou de non-blancs !

L’IA est raciste et c’est clairement de notre faute

La prudence est de mise, mais la méfiance doit s’accompagner de nuances. Adobe affirme mettre en place des garde-fous éthiques et s’appuie sur une base de données « sécurisée et responsable ». Pour autant, quand des images évoquant des faits négatifs aboutissent toujours aux mêmes visages ou vêtements, le doute s’installe. Et pour cause : aucun modèle d’IA ne peut encore garantir une neutralité totale. C’est pourquoi des organismes comme l’UNESCO militent pour plus de diversité dans les équipes de développement, et plus de transparence dans les jeux de données. Et vous, avez-vous déjà utilisé une IA comme Firefly pour générer des visuels… et été surpris (ou mal à l’aise) par le résultat ? Envie de réagir ? Partagez votre expérience ou posez-nous vos questions ! Merci de nous signaler toute erreur dans le texte, cliquez ici pour publier un commentaire .