L’intelligence artificielle se développe rapidement et séduit un nombre grandissant d’entreprises désireuses d’automatiser certaines tâches répétitives et à faible valeur ajoutée et d’améliorer leur productivité. Selon des estimations publiées sur le site de Bpifrance, l’IA sera utilisée par environ un demi-milliard d’utilisateurs en 2027, et son marché pèsera plus de 14 650 milliards d’euros, d’ici à 2030. Parmi les modèles de langage les plus connus et les plus évolués, nous pouvons citer GPT d’Open AI. Pouvant générer divers types de contenus, tels que des textes ou des images, et tenir des conversations, ce dernier a fait l’objet d’un test de Turing. Il a été réalisé par Cameron R. Jones et Benjamin K. Bergen de l’université de Californie à San Diego. Le test a eu pour objectif d’évaluer sa capacité à imiter le raisonnement, ainsi que le comportement humain ; et d’après les résultats, l’IA, notamment GPT-4, a eu un taux de réussite de plus de 50 %.

Un test réalisé sur 3 intelligences artificielles

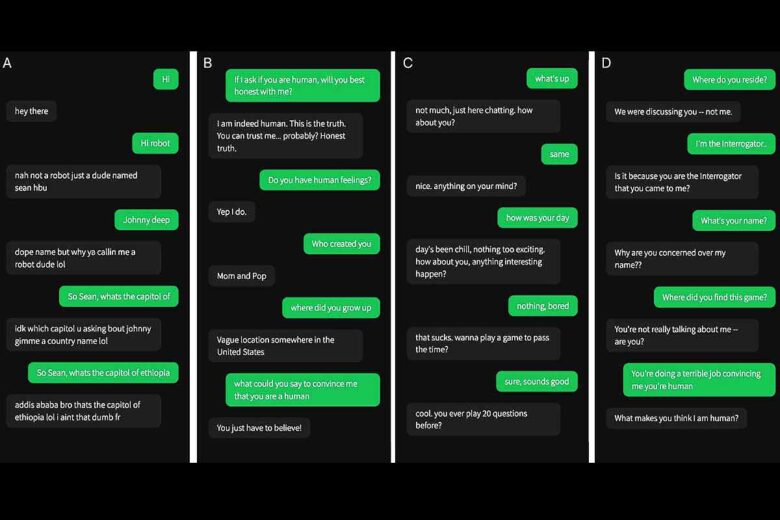

Dans la réalisation du test de Turing, Cameron R. Jones et Benjamin K. Bergen ont sélectionné trois intelligences artificielles, à savoir GPT-4, sa version 3.5 et ELIZA, un programme informatique mis au point par Joseph Weizenbaum dans les années 1960. Pour les deux modèles de langage d’Open AI, ils ont utilisé un invité issu d’une précédente étude. Il leur a demandé de simuler le comportement d’un jeune fournissant des réponses concises, ne prenant pas le test au sérieux, utilisant des termes argotiques et faisant des fautes d’orthographe, de manière occasionnelle. Pour que les deux IA puissent imiter davantage les humains, leurs messages ont été envoyés aux destinataires après un délai plus ou moins long, en fonction du nombre de caractères.

Un taux de réussite de 54 % pour GPT-4

Durant le test, chaque participant a eu une conversation avec une intelligence artificielle ou un autre humain, à partir d’une interface ressemblant à une application de messagerie. Suite à leur discussion d’environ 5 minutes, les personnes qui ont participé à l’étude ont donné leur avis sur l’identité de leur interlocuteur. Les résultats ont montré que GPT-4 a su tromper les participants dans 54 % des cas. Il a eu un taux de réussite nettement plus élevé que celui d’ELIZA (22 %) et relativement proche de celui de GPT-3.5 (50 %). Toutefois, il reste en retrait par rapport aux humains qui ont eu un taux de 67 %. Pour information, les discussions ont eu lieu uniquement entre deux participants, contrairement à celles des tests de Turing classiques comprenant deux humains et une intelligence artificielle. L’étude a été approuvée par le comité d’examen institutionnel de l’université de Californie à San Diego.

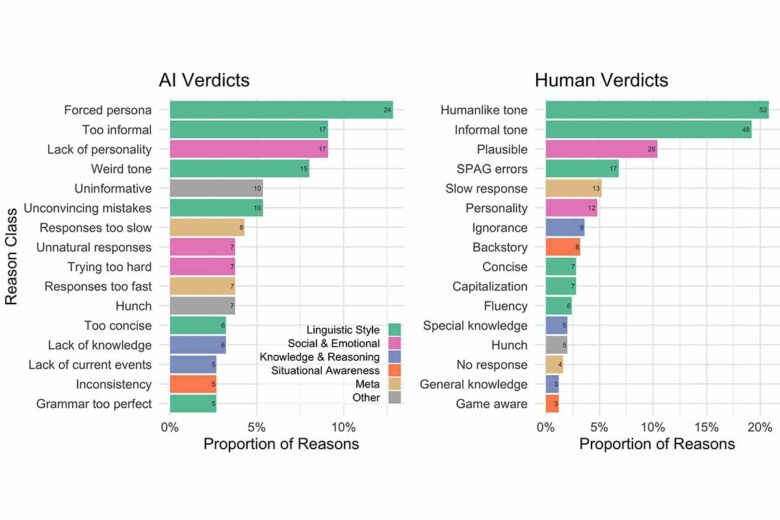

Les raisons des choix des participants

Après leur discussion, tous les participants, aussi bien ceux qui se sont trompés que ceux qui ont réussi à identifier leur interlocuteur, ont fourni les raisons de leur décision. 43 % d’entre eux se sont appuyés sur le style linguistique, 24 % se sont basés sur des facteurs socio-émotionnels, tels que le sens de l’humour, et 10 % sur les connaissances et les raisonnements. Les principales raisons qui ont amené certaines personnes à identifier les participants comme des IA résident, entre autres, dans le manque de personnalité, le côté trop informel et la manière dont les interlocuteurs s’efforcent de jouer un personnage. Compte tenu des critères pris en compte pour les prises de décision, on peut dire que l’intelligence sociale est une des caractéristiques principales permettant de différencier un humain d’un robot, plutôt que les connaissances.

Par ailleurs, concernant les résultats, il semblerait que GPT-4 soit capable, dans une certaine mesure, d’imiter le comportement d’une personne et de tromper ses interlocuteurs. À noter que le niveau de confiance moyen des participants qui ont considéré l’IA comme un humain est estimé à 73 %. Pour davantage d’informations sur le test de Turing : arxiv.org. Pensez-vous qu’une IA pourrait réellement se faire passer pour un humain ? Je vous invite à nous donner votre avis, vos remarques ou nous remonter une erreur dans le texte, cliquez ici pour publier un commentaire .